Что такое индексация сайта, как проверить и ускорить индексирование страниц

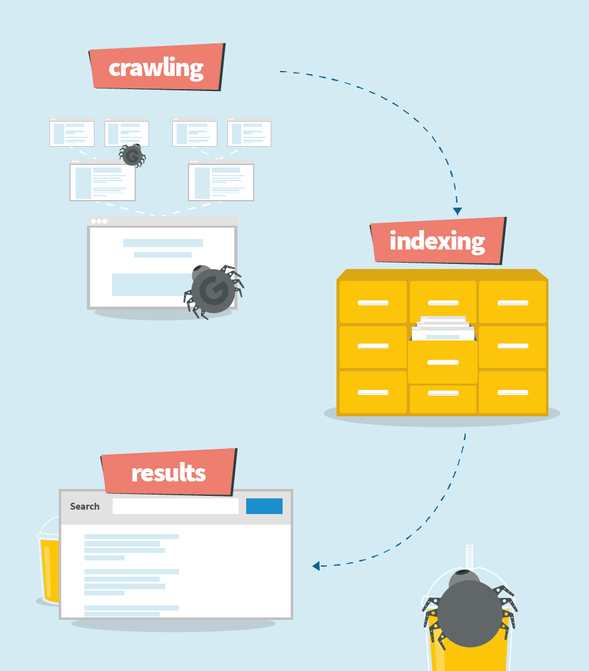

Задача SEO-специалиста и веб-мастера – оптимизировать сайт, сделать его достойным высших позиций в выдаче. Чтобы о ресурсе узнали пользователи Сети, он должен пройти проверку на соответствие требованиям Яндекса и Google и попасть в базу. Незримые агенты поисковых систем – роботы проводят подобные проверки и пополняют библиотеку данных постоянно. Это и называется индексацией сайта.

Целей у процесса две:

- Пополнить внутренний каталог системы сведениями о новых ресурсах.

- Предложить релевантные сайты людям, которые ищут информацию через поисковую строку.

Роботы собирают данные со страниц веб-сайта, оценивают ссылочную массу, текстовый и графический контент, структуру, мета-теги. От общего качества внутренней и внешней оптимизаций ресурса будет зависеть конечный результат его индексации. Чем больше «баллов» в проверке набрала конкретная страница, тем выше она окажется в выдаче по определенным запросам.

Важно: если сайт не оптимизирован, индексация сама по себе не даст ничего. Роботы либо проигнорируют неудачные страницы, либо добавят их в каталог, но впоследствии не выведут на первые страницы выдачи. За откровенно плохое состояние и черное SEO можно попасть под санкции и забыть о дальнейшем продвижении до устранения проблем.

Индексация – динамичный процесс. Новые и обновленные страницы роботы обходят постоянно – показатели меняются. Добавили хорошую уникальную статью – позиции выросли, решили раскручиваться с помощью хитрых дорвеев – знакомьтесь с фильтром «Минус 30» от Google и падением в выдаче ровно на 30 пунктов.

Годы, когда неумелые роботы добавляли в ТОП переспамленные малополезные сайты, прошли. Добиться индексации и проверить ее – легко (рассмотрим далее), обеспечить качественный скачок по ее итогам – куда сложнее. Алгоритмы оценки и требования к ресурсам Яндекс и Google не скрывают. Необходимо стремиться к улучшению состояния сайта, чтобы проверка проведенной индексации не стала холодным душем.

Реализация индексации

Роботы поисковых систем с радостью индексируют сайт, о котором им что-то известно. Трастовому ресурсу с хорошей видимостью, отличным трафиком и качественными внешними ссылками напоминать о себе не приходится. Всем остальным веб-сайтам стоит «подать заявку», чтобы «пауки» провели обход и собрали данные.

Алгоритм для Яндекса:

- Создайте карту сайта (Sitemap.xml).

- Добавьте сайт в Яндекс.Вебмастер и загрузите sitemap в спецразделе.

- Оптимизируйте файл txt

Принцип для Google:

- Запрос одной страницы проводится через Google Search Console.

- Если на сайте много URL, нужно создать Sitemap и дать к нему доступ роботам ПС. Подробная инструкция.

- Не забудьте про robots.txt.

Можно ничего не делать и ждать, пока робот сам найдет сайт: рано или поздно это случится. Чревато серьезной потерей времени и бесполезными тратами денег на продвижение.

Важно: в случае с Google допускается взаимодействие без sitemap (если на сайте менее 100 URL). Когда главная страница разумно связана с остальными страницами, отправки ее адреса через поисковую консоль будет достаточно для индексации всего ресурса.

Роботы (пауки, краулеры) Яндекса и Google делятся на специализированные группы. На вершине «иерархии» – главные боты. Вместе с ними работают роботы оценки часто обновляемых страниц и другие виды ботов. Общая индексация может включать анализ:

- графических элементов;

- текстового контента (статей и новостей);

- зеркал;

- видео;

- мобильных версий сайта.

Управление поисковым роботом

Роботы поисковых систем видят все «внутренности» ресурса. Бездушные машины нельзя подкупить или обмануть. Однако законным методом влиять на процесс индексации можно. Стоит это делать по многим причинам:

- Существует понятие краулингового бюджета – количества URL, которые ПС хочет и готова просканировать и отправить в индекс. Важно, чтобы робот просканировал при бюджете в 100 страниц 100 полезных и качественных URL, а не 10 хороших и 90 – технических и не имеющих ценности.

- Служебные и технические (для внутреннего пользования) URL вообще не нужно отправлять на индексацию.

- Если у оптимизатора есть стратегия развития страниц «группы А», логично поднять приоритетность их проверки.

Прописать правила и оптимизировать индексацию можно с помощью файла robots.txt. В документе используются важные директивы:

- User-agent – принадлежность нижеследующих правил к определенной поисковой системе (Yandex, Google, Yahoo и т. д.).

- Allow – разрешение на индексирование.

- Disallow – запрет индексирования (всего сайта или отдельных URL).

- Sitemap – адрес карты веб-сайта.

Сразу закройте от роботов: служебные страницы (панель администратора, CMS-файлы, корзину), бесполезные для SEO URL и дубли.

Robots.txt нужно разместить в корневом каталоге ресурса. Провести валидацию файла (проверку на соответствие) можно в панели Яндекс.Вебмастера «Инструменты» и в Google Search Console.

Если ресурс находится на стадии разработки/доработки, лучше полностью закрыть его от индексации для всех ПС в robots.txt:

User-agent: *

Disallow: /

Срок индексации и ее ускорение

Яндекс использует свой алгоритм, который настроен на максимальное исключение из выдачи некорректных и бесполезных сайтов заранее. Тщательный подход увеличивает срок индексации. В среднем роботы Яндекса тратят на индексацию нового сайта до 1 месяца. В Гугл апдейт может проходить несколько минут или дней.

Важно: проведенное Google индексирование не гарантирует сайту место в выдаче ПС!

Скорость роботов напрямую влияет на актуальность информации, которую получают пользователи поисковой системы. После обновления мета-тегов , ассортимента или цен на товары, публикации свежего и важного контента хочется побыстрее привлечь читателей (клиентов). Какой SEO-оптимизатор не стремится поднять проект на пару-тройку строчек в выдаче по важным запросам?

Простых способов ускорить процесс индексации со 100% гарантией нет, но отдельные меры помогут избежать «простоя»:

- Вдумчивая подготовка robots.txt и Sitemap и контроль их обновления.

- Регистрация ресурса в Яндекс.Вебмастере и GSC для анализа данных, контроля, доступа к инструментам.

- Внутренняя оптимизация (проработка логичной структуры, создание полезного контента).

- Внешняя оптимизация (ссылки на ресурс на авторитетных сайтах с внушительным трафиком).

- Перманентное обновление веб-сайта и работа над его технической составляющей. Редкие обновления ведут к редким визитам роботов.

Проверка индексации

Для проверки статуса индексации и количества URL в выдаче поисковых систем существуют инструменты:

- Панели веб-мастеров от Яндекса (раздел «Страницы в поиске») и Google (раздел «Статус индексирования»).

Важно: в инструментах Яндекс.Вебмастера можно проверить индексацию отдельной страницы , отметить важные для анализа URL. Для глубокого анализа процессов индексации воспользуйтесь разделом «Статистика обхода».

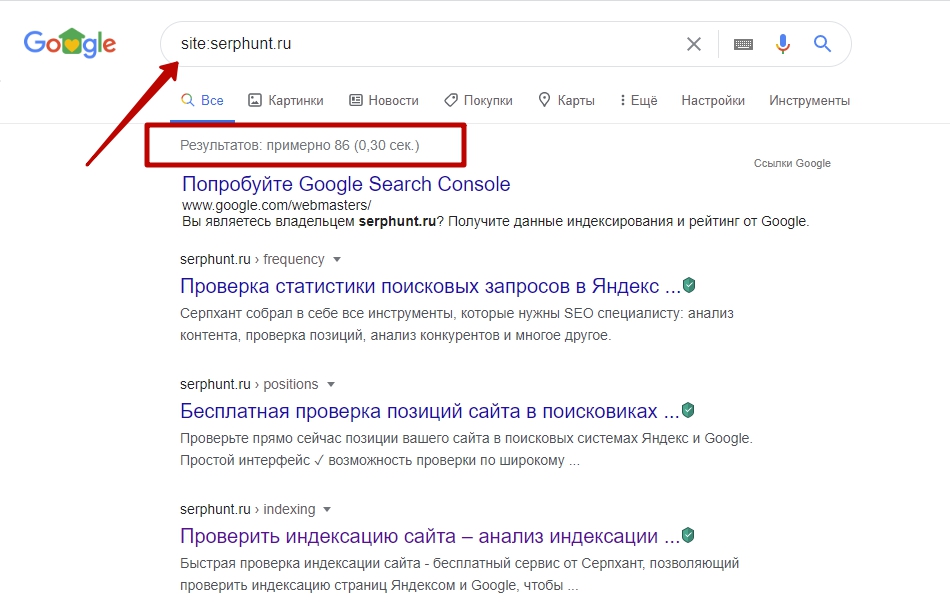

- Команда (оператор) site:. Необходимо вручную ввести в поисковой строке оператор и адрес сайта. Количество проиндексированных URL будет показано рядом со строкой. Метод подходит для Яндекса и Google. С помощью дополнительных опций поиска можно увидеть проиндексированный объем за час, день, неделю и т. д.

При большой разнице показателей в Гугле и Яндексе можно предположить, что на веб-сайт наложен фильтр.

- Сервисы, плагины, программы и букмарклеты:

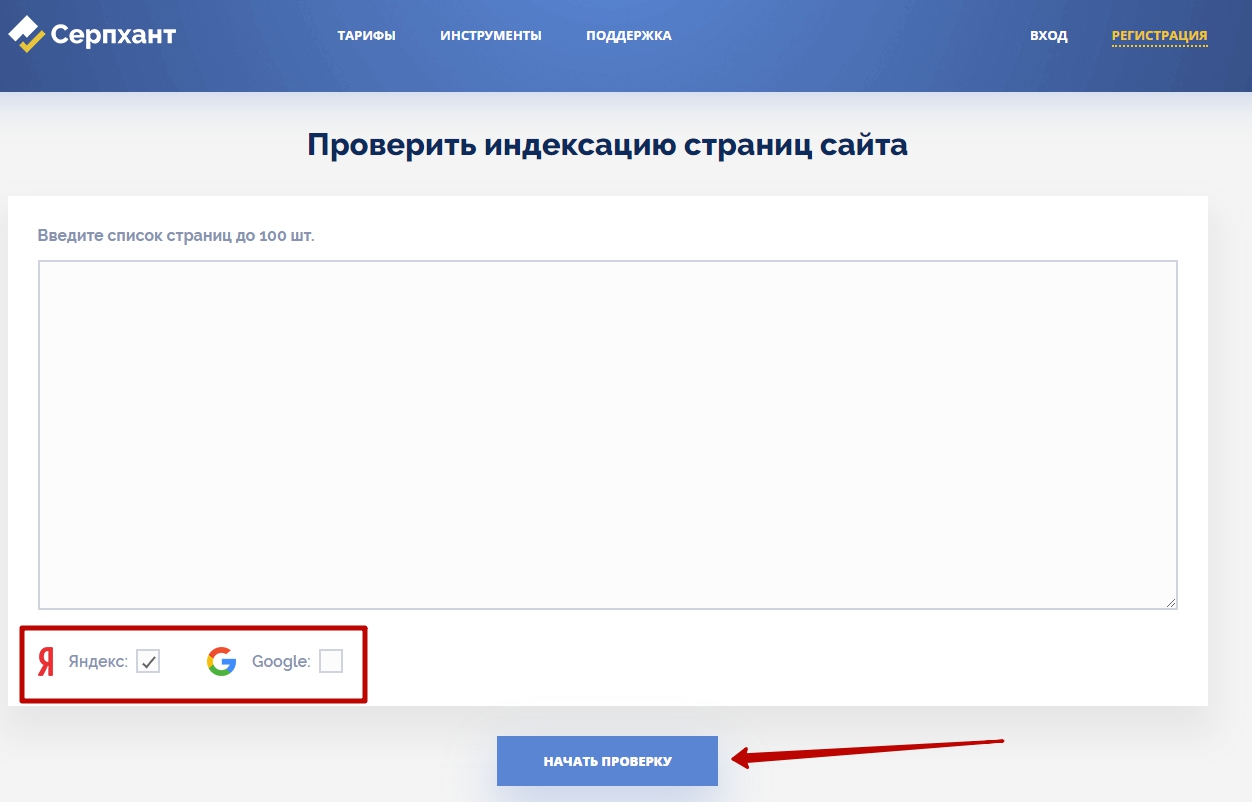

- Серпхант предлагает свой бесплатный онлайн-инструмент для проверки индексации в обоих поисковиках.

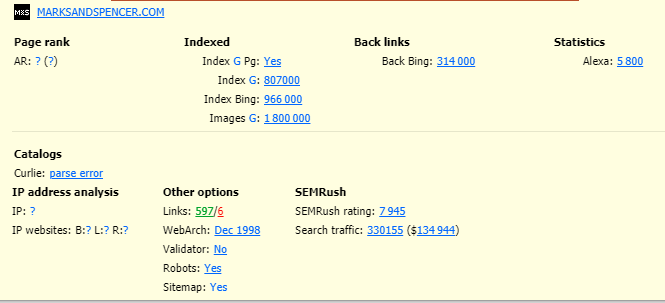

- Другое популярное решение – RDS Bar.

Компания RDS выпускает плагины анализа сайтов для основных браузеров и функциональные SEO API-утилиты для Windows.

- Букмарклеты – отдельные мини-javascript-программы, которые сохраняются как закладки браузера и быстро выдают результат анализа. Воспользуйтесь букмарклетами «Google Index» и «Индексация сайта Y» (инструкция и полезный каталог для SEO-специалистов и веб-мастеров).

- Комплексные десктопные программы от Netpeak – Spider и Checker – с платной лицензией. Spider позволит провести скан всего веб-сайта и получить данные о кодах ответа, редиректах, ссылках, мета-информации и т. д. Встроена функция оповещения об ошибках. Готовый список проверяется в Checker. Формируется полный отчет об индексации.

При всей глубине системы индексации многое зависит от стратегии и качества оптимизации. Белое SEO + высокая релевантность = залог успешного ранжирования ресурса с высокими позициями в выдаче. Хотите идеальных результатов индексирования – дайте пользователям лучший в Сети ответ на их запросы в удобной оболочке. Роботы это оценят мгновенно.

Проблемы с индексацией сайта

Причины, по которым индексация может отсутствовать или быть затруднена:

- Молодой (новый сайт). Яндекс и Google сознательно «придерживают» молодые ресурсы (вспомним фильтр «Песочница»), и молниеносная индексация в их планы не входит. Нужно набраться терпения (до нескольких месяцев).

- Карты сайта нет или она составлена неверно. Sitemap – путеводитель для роботов. Без него они будут блуждать долго.

- Ошибки. Найденные роботами проблемы нужно устранять. Информация доступна в панелях веб-мастера.

- Опечатки и описки в robots.txt. По незнанию или случайно можно одним тегом закрыть важные файлы. Нужно помнить о структуре и вложенности папок.

- Низкая скорость загрузки. Бич, который тормозит не только появление страниц на мониторе, но и скорость работы роботов.